在国防部合作项目被员工要求关闭的风波之后,Google 发布了公司在使用人工智能的十一条准则。

其中包括 Google 进行 AI 研发的七个目标,和 Google AI 绝不会进入的四种应用场景,堪称 AI 道德规范的“谷11条”。

CEO 颂达尔·皮柴 (Sundar Pichai) 在发布准则的公开信里,也对国防部项目争议做出了直接回应,表示今后不会让 AI 涉及武器化的应用,但并未“一刀切”,和政府、军方划清界限。

作为 AI 界的带头大哥,Google 并未对多如牛毛的 AI 应用领域一一作出指引,但这么多年经历了这么多“坑”之后,这本“谷11条”所体现出的智慧,也许会对所有关心 AI 道德问题的人有很大的帮助。

下面,硅星人就带大家来捋一捋“谷11条”背后的思路。

Google 眼中“好 AI”的标准

首先,设计产品之初,价值观就要正。

Google AI(原 Google Research)研究院克里斯汀·罗伯森曾向硅星人阐释,公司研发 AI 的领导思想是:按照对社会有益的原则进行设计,创造世界最棒的产品,让这些产品实现商业化,在竞争中保持领先,同时,让这些产品为世界做出贡献。

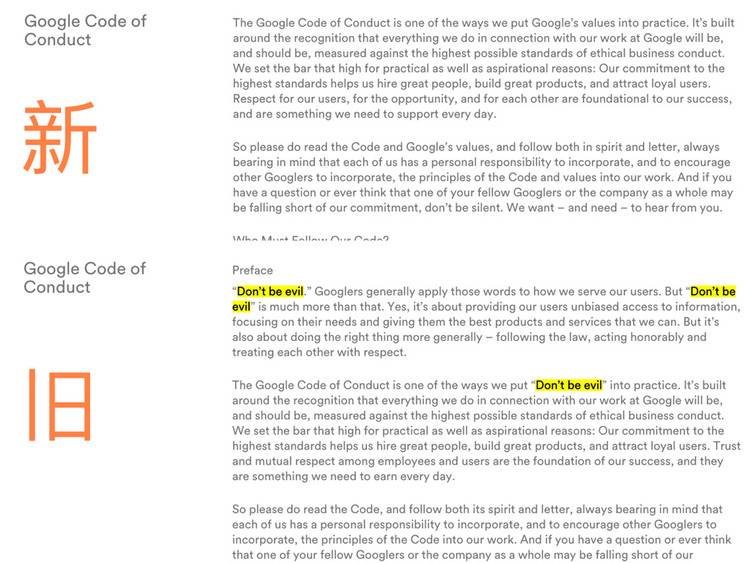

Google 一向强调不作恶 (don’t be evil) 的价值观,但它从来不是一家慈善机构。和所有科技公司一样,它需要靠好产品赚钱,只不过,在对“好”产品的定义上,Google 和许多公司明显不同。

“谷11条” 一上来就告诉员工,AI 产品一要对社会有益,二不能加重现实社会已有的问题:

1 要对社会有益

… 当我们思考 AI 潜在的应用场景时,我们将会把一系列社会和经济因素考虑进内,在那些整体收益远远超过可预见风险和弊端的领域,进行推进。

2 要避免制造或加强不平等的偏见

AI 算法和数据集可以反映、加强或减少不平等的偏见 … 我们将努力避免人们受到不公正的影响,尤其是与种族、民族、性别、国籍、收入、性取向、残疾以及政治或宗教信仰等敏感特征相关的人群。

确保方向正确后,接下来 Google 要保证自己的产品是业界最棒的。准则的第三到七条列出了好产品需要满足的标准。字里行间继续体现着以人为本的理念。

3 要保证安全性

4 要对人负责 … 我们的 AI 产品将易于接受合适的人类指导和控制

5 要结合隐私设计原则

6 要维持科学卓越的高规格

7 要可以用于符合原则的使用场景

仔细阅读这些准则,你甚至可以找到对应的具体产品。

比如准则中 Google 提到,“AI 加强了我们理解大规模内容含义的能力,我们将努力利用 AI 提供高质量和准确的信息”。这说的不就是最近上线的新版 Google News 嘛。

此外可以看到,在这些对产品标准的要求中,Google 还加入了对最近科技界激辩的话题的思考:比如数据隐私,比如 AI 发展对人类本身可能带来的威胁。

对国防部合作风波的回应

“谷11条”的结构是“七要四绝不”。

举了七个目标后,Google 提出了四个绝对不碰的领域。首先:

我们不会将 AI 应用于:

1 带来或可能带来伤害的技术

2 武器或其他旨在给人们造成伤害的技术

做出这段表述的背景:今年 3 月时,有媒体曝光 Google 的一份内部文件,显示该公司参加了五角大楼的无人机计划 Project Maven,帮助开发应用于无人机的 AI 系统。

与此同时,又有媒体曝出 Google 在内部行为准则里删掉了有三处“ 不作恶” 的文案。

和恨不得公司再坏一点的 Facebook 不同,大批 Google 员工对这个事实感到愤怒不满。内网激烈的讨论后,超过三千名员工联名上书 CEO,要求退出项目。

最终,公司向员工和外界妥协,宣布 2019 年国防部合同到期后不再与续约。

正是这件事,推动了“谷11条”的诞生。据报道,Google 创始人拉里 佩奇、谢尔盖 布林、CEO 皮柴和其他高管一起花了数月,最终制定了这版新的 AI 准则

不过,在这两条表述里,Google 并没有表达以后完全跟政府及国防部门彻底交割。

在强大的合作关系面前,Google 是纠结的,而这并没有错误。比如在云计算上,国防军事是个潜力巨大的领域。Google 的竞争对手亚马逊、微软都在积极竞标国防部的云计算及存储业务,Google 不可能因噎废食。

不过既然做了决定就要承担后果,Google 的纠结之后肯定还会引发新的争议和讨论,Google 只好表示准则会根据公司新的理解而不断改进。

自己不作恶,也不让别人作恶

更具体来说,坚决不允许别人利用自己的技术作恶,这是不能跨过的底线。

四绝不的后两条:

AI 不会用于

3 收集或使用信息用于监控并违反国际规范的科技

4 技术的目的违反了广泛接受的国际法与人权原则的科技

从这两个条款可以明显看到,“谷11条”再次稳固了不作恶三个字的地位,而且还更进了一步:不仅自己不作恶,还要防止别人利用 Google 的技术作恶。

这在上面第七条的 AI 目标中也有体现:

许多技术同时拥有很多用途。我们会努力进行识别,限制可能有害或被滥用的应用。我们会评估以下因素:Google 希望借保证自己的 AI 技术不被滥用,这么做势必意味着跟更多可能得到的利益说再见。一个直接影响可能是 Google 重返某些市场的难度会变得更大。

首要目的和用途……以及与有害的用途有多接近

本质和独特性:我们的技术是普世的还是有独特应用场景的

规模:这项技术的使用是否会带来重大影响

Google 在其中参与的性质:我们是在提供普通的工具,还是为用户做集成的工具,还是在开发定制解决方案

但没有人会因为 Google 坚持它的真诚和正义而怪罪它。有些事情必须做出取舍。

博客文章中,皮柴再次提到 2004 年 Google 上市时提到的两个原则:“让世界变得更好”,和“不作恶”:我们当时就表明了我们要用更长远目光看问题的愿望,即使这意味着需要作出短期的牺牲。我们当时这样说,我们现在还是这样相信。

Google 的准则体现着一家已经 20 岁高龄的新技术公司,对可能是未来最关键技术,和道德的思考。它给出了一个宽泛,但又方向明确的指引,让一些事情不再停留在想法和概念。

这本“谷11条”,或许也能推动其他公司,扔掉“技术中立”的保护伞,更诚实地参与到这个话题的讨论中。

网站导航

网站导航

相关文章

相关文章

精彩导读

精彩导读

热门资讯

热门资讯